3teneとRealSense D435とnuitrack&WEBカメラでVTuberになろう

目次

今までの記事#1~#3ではVTuberになるための支援ツールや人の動きの読み取りデバイスなどを解説してきました。

ソフトウェアのインストールや各デバイスの設定が終わったらいよいよ実践です。

RealSenseとの距離感について

RealSenseを使用して骨格検出でアバター操作をする上で、最後の壁があります。

それは部屋の広さです。

適度な距離がないとRealSenseのカメラの全身をおさめることができません。

なおかつ後ろの壁からもある程度離れて立たないと壁と人との距離が近くなりすぎて誤検知してしまう場合があります。

全身を認識させるには少なくとも2m以上カメラと距離を取って、後ろの壁とも1m以上離れた場所に立つ必要があります。

僕の狭い部屋でこの場所を探すのに苦労しました。

また、以前の記事でご紹介した通り全身が入る距離に人が立った場合、RealSenseのカメラでフェイストラッキングをしようとすると距離が離れすぎて顔を認識できない問題もあります。(これに関しては別のWEBカメラを設置することで問題を回避できます)

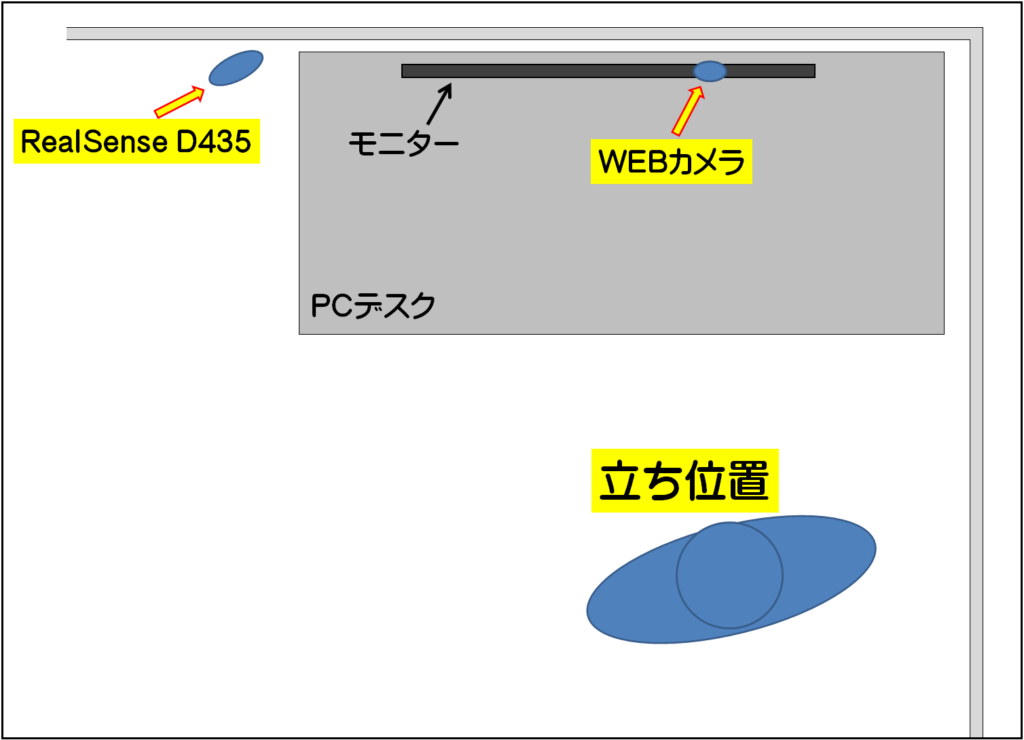

僕も部屋のいろいろな場所で試した結果、下の図のような感じで落ち着きました。

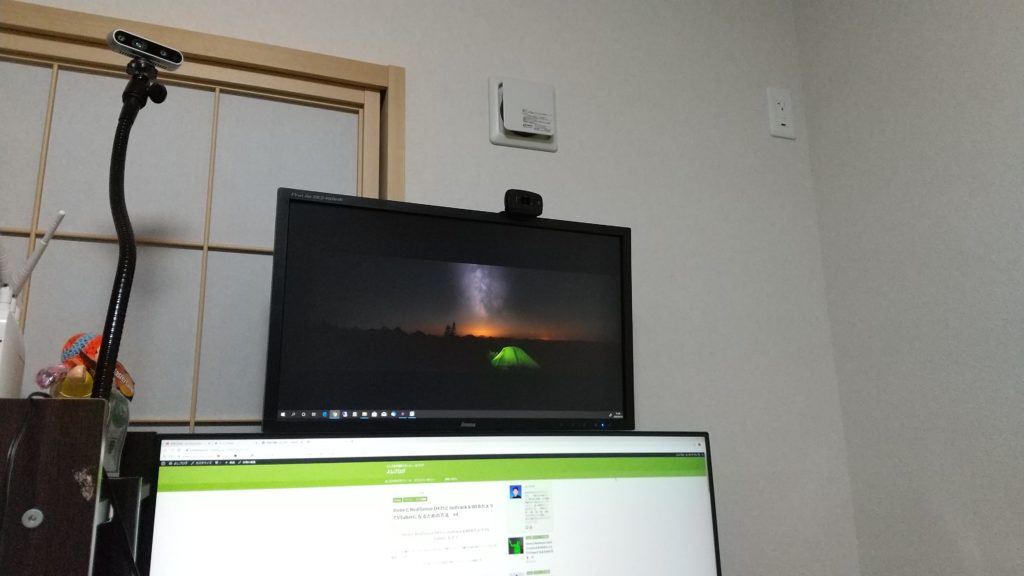

写真だとこんな感じです

これでも足元をうまく認識できませんが、YouTubeに動画を出すときは基本的に上半身しか映しませんのでヨシとしました。

あと服装ですが、黒い服はダメです。なるべく明るめの白っぽい服のほうがうまく認識できます。

実際に3tene PROでアバターを動かしてみよう

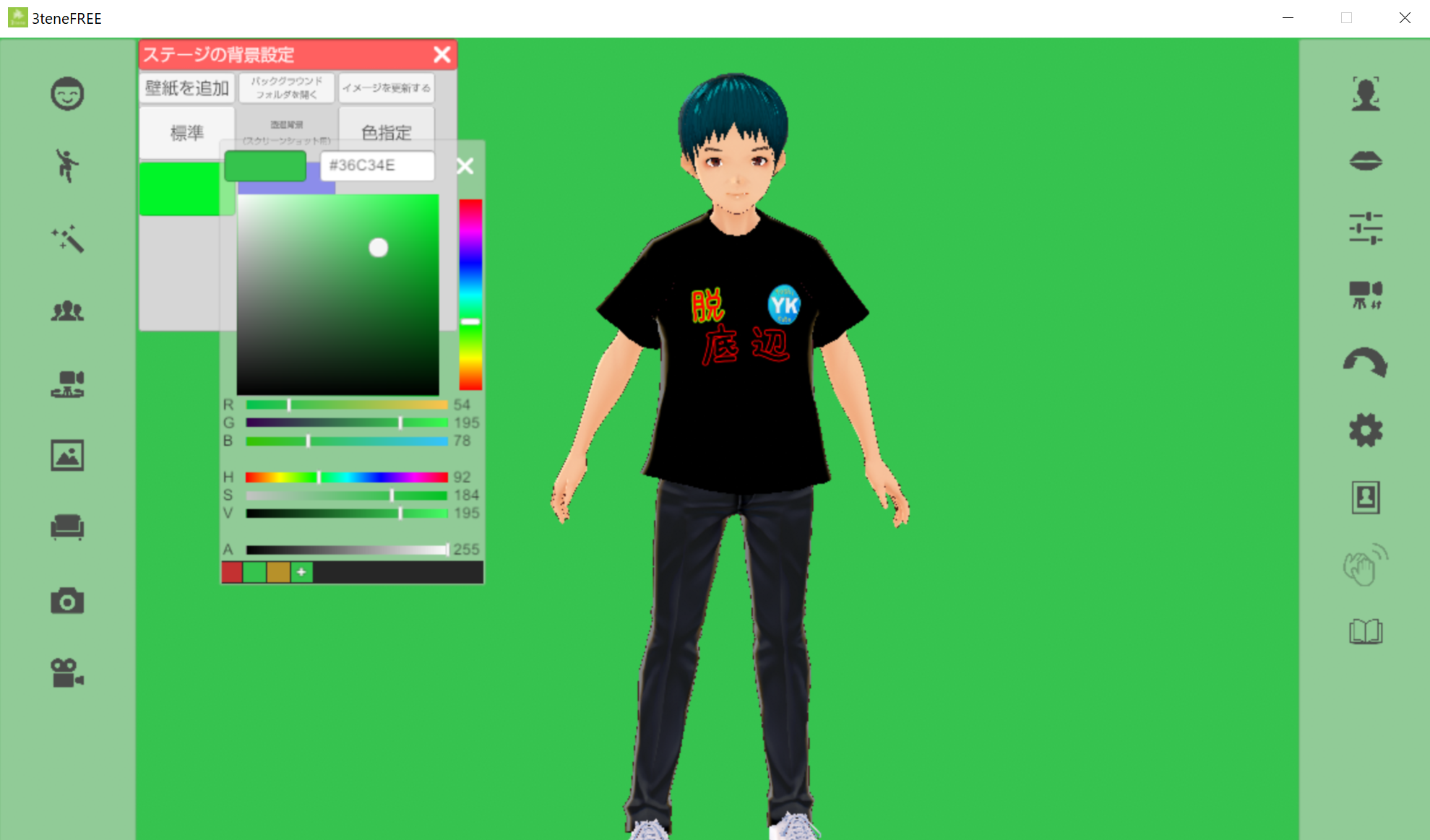

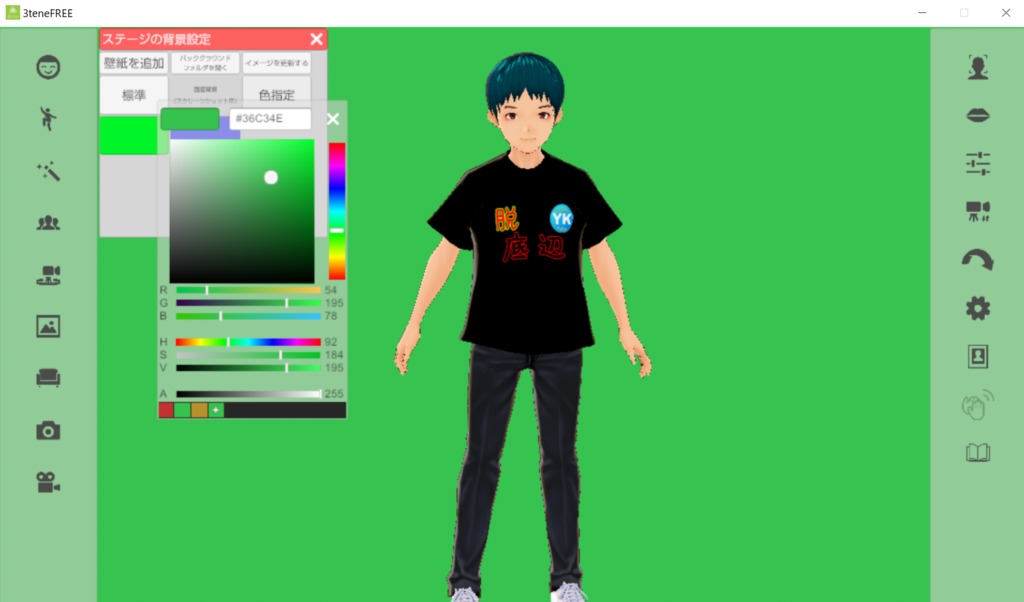

3teneの操作画面

RealSenseが人物を検知するまでの間、カカシポーズで待機しています。

骨格認識ができる適切な距離になるとアバターがそれに合わせて動き出します。

このちょうどいい距離感は動きを見ながら探ってみてください。

フェイストラッキングをするカメラはWEBカメラを指定して、RealSenseのカメラよりも体に近い位置に来るように工夫してみましょう(見取り図参照)

カメラの位置や角度を調整したらいよいよ撮影です。

左下にある録画ボタンをクリックして録画スタートです。

僕の場合はYouTubeの動画の中にアバターのみを合成したかったので、背景をグリーンにしました。

動画編集ソフト(Premiere Elements)でビデオマージ設定をすれば簡単に合成できます。

実際に録画したデータがこちらです。

完成した動画はこんな感じ

上記の録画データはよし工房のチャンネルにアップされている動画で使用しています。

こちらもよかったら参考にしてみてください。

いかがだったでしょうか?

無事にVtuberになることはできましたか?

今後はnuitrackを$買いでライセンス購入する方法や、骨格検知録画をしているときに表情や手を動かす方法などを記事にしていきたいと考えています。

表情や手の動きはキーボードにショートカットを割り当てることで簡単にできますが、キーボードを操作する動きが骨格に反映されてしまいますので、このあたりをうまく考えていきたいと思います。